Constats

Avant toute autre considération, il faut avoir en tête que la traduction française de artificial intelligence nous emmène au moins partiellement sur une fausse route, puisque intelligence en anglais signifie aussi l’échange de renseignements, notion qui, une fois associée à artificial, prend un sens bien différent de celui que nous traduisons par « intelligence artificielle ».

L’intelligence Artificielle (IA) est un concept porteur d’une fascination qui peut déboucher aussi bien sur des peurs irraisonnées que sur des espoirs démesurés : spectre d’une domination sur l’Homme de la machine – Frankenstein devenue incontrôlable ou panacée devant nous décharger de toutes les tâches pénibles et nous soulager de tous les maux. Entre Gorgone désincarnée ou Camarde pour les uns, Graal pour les autres, quand son statut ne relève pas de celui de miroir aux alouettes en raison des impostures commises en son nom … la première d’entre elles portant sur le mot même d’intelligence.

L’expression voit le jour dans les années 1950 et le concept suscite alors de nombreux espoirs et fantasmes. L’IA est un ensemble de techniques permettant à des machines d’accomplir des tâches et de résoudre des problèmes normalement réservés aux humains comme reconnaître et localiser les objets dans une image, planifier les mouvements d’un robot pour attraper un objet, ou encore traduire un texte. Depuis quelques années, on associe l’intelligence de ces systèmes aux capacités d’apprentissage.

Après quelques décennies et désenchantements, deux ruptures technologiques majeures redonnent au concept des lettres de noblesse et permettent d’envisager des développements à nouveau prometteurs :

- La puissance de calcul des ordinateurs.

- Les techniques d’apprentissage profond (deep learning sur des architectures de réseaux de neurones artificiels) associées aux données massives (ou big data).

L’IA est connue du grand public avant tout pour les prouesses réalisées par les machines capables de battre des champions de jeux considérés comme « intelligents » : échecs et jeu de Go principalement, voire le Poker, performance fascinante car nécessitant d’imiter le bluff des humains.

Mais les avancées récentes concernent des domaines de plus en plus nombreux (médecine, tout d’abord, sciences en général, droit et justice, …) incluant à présent les domaines du marketing, de la publicité et plus largement de la communication. Après la bataille ouverte par l’Europe sur les données personnelles, s’ouvre à nous un second acte qui portera sur les données sectorielles (santé, transport, environnement, consommation, etc.). Or cette seconde étape implique l’échange libre des données et leur partage. C’est pourquoi il est important d’ouvrir un débat sur l’émergence d’une I.A. éthique et soutenable.

Les applications pour ce marché sont de plusieurs natures :

- Le ciblage publicitaire : qui existait d’ailleurs bien avant Internet. Il devient grâce aux données disponibles (big ou pas …) de plus en plus fin et précis.

Mais un programme informatique permettant un tel ciblage n’est pas toujours un algorithme [1] et un algorithme n’est pas nécessairement de l’IA … - La relation client : l’arrivée des « chatbots » ou agents conversationnels supposés remplacer un échange interpersonnel entre un service client et le client.

- La compréhension client : au travers de segmentations de plus en plus dynamiques, rapides (en temps réel), et dont on promet qu’elles sont plus pertinentes.

- L’offre produit et/ou publicitaire : grâce à cette meilleure compréhension et aux possibilités technologiques d’adaptation en temps réel (prix, produit, message …).

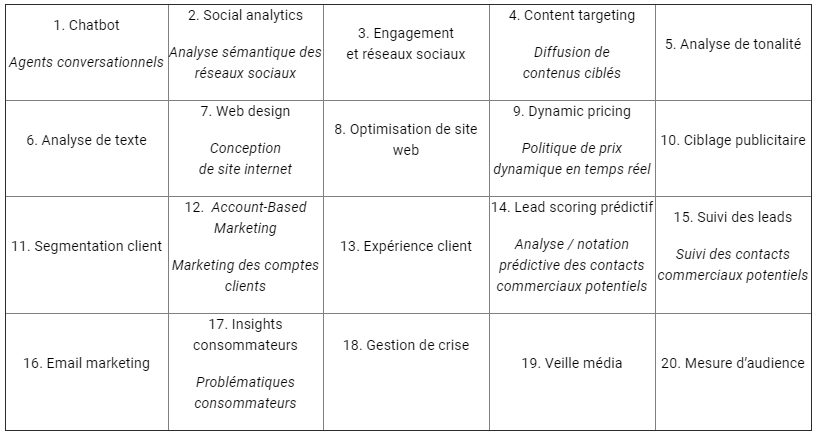

Kantar Media inventorie des utilisations de l’intelligence artificielle pour le marketing en 2017 [2] présentées sous les vocables suivants par l’institut (les italiques représentent notre traduction) :

- L’utilisation d’un jargon fortement teinté d’anglicismes et la tentative de rassembler sous la bannière de l’IA des concepts qui relèvent parfois simplement d’une utilisation, certes maline (voire intelligente …) de la programmation informatique et du traitement des données (pas toujours massives), illustre certains des aspects qui seront abordés dans cet avis : les quasi impostures consistant à utiliser la terminologie IA en toute circonstance, les difficultés du public, y compris professionnel, à réellement comprendre ce qu’est et surtout ce que n’est pas l’IA et par voie de conséquence la nécessaire pédagogie, voire culture du sujet, à développer auprès des différents publics.

- Mais pour revenir au propos de Kantar Media, lorsqu’on détaille la description que fait l’institut de ces innovations, on constate qu’il s’agit presque systématiquement d’apporter, à l’aide d’outils technologiques, une aide, une réponse à un besoin d’automatisation de tâches dévolues à la marque et/ou au public, afin de rendre la relation client, donc la façon de communiquer avec lui, sous toutes ses formes, plus pertinente, plus fluide, plus rapide.

On voit se développer aujourd’hui des utilisations d’IA qui « prennent différentes formes » :

- celle d’une voix : les agents conversationnels (sur les sites Internet ou comme moteurs de recherche de smartphones …)

- celle d’un objet : certains objets connectés (pèse-personne, caméras de surveillance, téléphone …)

- celle d’un objet conversant : les assistants personnels intelligents ou API (Google, Amazon…)

- celle d’un robot : humanoïde ou non (Pepper, Nao, Romeo, …)

Si les robots ont pour le moment des applications plutôt tournées vers l’aide aux personnes en difficulté, on commence à les apercevoir dans l’univers des boutiques (essais pilotes chez Carrefour, Darty…) ou plus largement dans l’univers commercial (SNCF, Costa Croisières…) avec un intérêt nettement plus marqué au Japon que dans les pays occidentaux pour le moment (on commence à voir des robots dans les restaurants japonais, ayant des fonctions de serveurs et capables de « produire quelques blagues » au grand bonheur des clients ! ).

Les robots qui embarquent des modules d’IA n’ont pas encore dévoilé toutes les possibilités en matière de communication au sens publicitaire du terme. Pour cette raison, le présent avis abordera certains aspects liés aux robots, mais n’approfondira pas le sujet en plein devenir, tout en préconisant une veille attentive.

La société doit prendre la mesure des défis et des enjeux qui se posent à elle par le déploiement de l’IA à tous les niveaux. L’Intelligence Artificielle est devenue un sujet de société aussi bien en raison des fantasmes qu’elle génère que de la réalité des enjeux qui l’accompagne. Une synthèse reste à trouver entre le point de vue utilitariste de l’IA et la nécessité de l’enfermer dans un cadre de régulation.

- Le gouvernement français a commandé en septembre 2017 un rapport sur l’intelligence artificielle [3], rendu par Cédric Villani, député LREM, mais surtout brillant mathématicien lauréat de la médaille Fields.

- Ce rapport a débouché sur une stratégie [4] en quatre axes en faveur de l’intelligence artificielle en France présentée par le Président de la République en mars 2018. Les priorités sont la recherche, l’ouverture des données, les enjeux éthiques et sociétaux.

- De très nombreux articles aussi bien de la presse généraliste que de la presse spécialisée ou de la presse scientifique abordent différents aspects de l’IA.

- Des réflexions éthiques voient régulièrement le jour. Elles sont avant tout centrées sur le respect de la vie privée et l’utilisation des données mais aussi sur les relations homme-machine ou robot-machine et souvent sur les responsabilités afférentes.

- Il est par exemple question des véhicules autonomes [5] et notamment des prises de décision des machines, de la non homogénéité de ces décisions liées aux facultés d’apprentissage automatique dont elles sont dotées, qui fait de chacune d’entre elles une machine singulière. La conséquence est que ceci rendra peu prévisibles, voire imprévisibles les comportements qu’elles adopteront. Cette prédisposition particulière de l’organisme qui fait qu’un individu réagit d’une manière personnelle à l’influence des agents extérieurs [6], appelée idiosyncrasie, serait cependant faible voire très faible si on l’étend aux apprentissages automatiques et donc à l’IA.

- De nombreux scientifiques considèrent qu’« il faut créer un comité national d’éthique du numérique», distinct de la CNIL [7].

- D’ailleurs, dès 2012, des acteurs publics français, réunis au sein de l’Alliance Allistene [8] ont décidé de créer la CERNA – Commission de réflexion sur l’Ethique de la Recherche en sciences et technologies du Numérique de l’Allistene) avec « pour mission d’aborder les questions d’éthique du numérique du point de vue des sciences et des technologies » [9].

- Plus particulièrement à propos des robots, les questions de l’inclinaison naturelle de l’humain vers un anthropomorphisme de l’I.A. doivent être abordées dans toutes leurs dimensions. Le roboticien Raja Chatila [10] souligne l’importance de bien comprendre ce que sont les robots, leurs potentiels et leurs limites [11]. Cf. aussi Serge Tisseron, psychiatre et auteur du livre “Le jour où mon robot m’aimera” (Albin Michel, 2015). Il est également producteur d’une émission sur France Culture « Matières à penser » qui traite spécifiquement de l’interaction Homme – Machine.

- Le Professeur et Chercheur Laurence Devillers, membre de la CERNA d’Allistène [membre du CEP]. Elle propose « 11 commandements » dans son livre « Des robots et des hommes » [12]. Elle a participé avec la CERNA dès 2014 au rapport « Ethique de la recherche en robotique » mettant en avant des préconisations à destination des chercheurs en matière de robotique [13], et a souligné l’importance de bien comprendre les apports et biais de l’apprentissage machine et du deep learning dans le rapport sur l’éthique de la recherche en apprentissage machine en 2017 [14].

- La CNIL a publié en décembre 2017 un rapport proposant des règles éthiques pour le développement de l’IA [15].

- Ces réflexions n’abordent pas ou peu le champ de la publicité, même si certaines d’entre elles pourraient y trouver une déclinaison directe, comme on le verra plus loin.

Au-delà de la réflexion éthique, des prises de position que l’on peut qualifier de « radicales » émergent. Ainsi, l’AFCIA [16], Association Française Contre l’Intelligence Artificielle, a vu le jour en 2015 fondée par « des bénévoles qui désirent susciter un débat au sein de la collectivité ». En réalité l’association milite pour « l’interdiction légale de toute recherche en Intelligence Artificielle ». Elle revendique un statut non scientifique. Ignorante en apparence ou détractrice par principe de ce que représente la démarche scientifique, elle considère tout chercheur en IA comme étant « juge et partie » et ayant « un point de vue biaisé du fait de (sa) formation, de (sa) profession et de (ses) centres d’intérêt ». Par ailleurs, l’AFCIA exprime des convictions qu’elle ne présente jamais comme des hypothèses (sur lesquelles il pourrait d’ailleurs être intéressant de se pencher), mais comme des certitudes énoncées sans démonstration, mais avec une vigueur supposée la remplacer … Transhumanisme et IA semblent également liés de manière inéluctable pour l’AFCIA qui, sur fond d’Apocalypse [17], affirme qu’« il s’agit ni plus ni moins que de faire de l’homme un dieu ».

Si les positions de l’AFCIA peuvent sembler excessives, elles sont néanmoins révélatrices d’un état d’esprit alarmiste, qui trouve probablement ses fondements dans des inquiétudes nées à la fois de questions légitimes non posées ou mal posées et de questions restées sans réponse ou en ayant eu de mauvaises …

Il convient donc de prendre à bras-le-corps tous ces enjeux, sans dogmatisme, donc sans idée préconçue, dans un cadre de réflexion rigoureuse qui, pour cet avis, adaptera les recommandations à la thématique publicitaire.

Problématiques

Les problématiques peuvent être regroupées en sept dimensions :

- Les données

- L’IA repose sur l’utilisation de nombreuses données, personnelles ou non.

- Ce point renvoie, d’une part, à l’Avis « Big Data » [18] du CEP publié en décembre 2016, d’autre part au règlement général sur la protection des données(RGPD), qui remplace la directive européenne de 1995 : il est entré en application le 25 mai 2018.

- L’imposture sémantique

La terminologie « Intelligence Artificielle », comme tout concept novateur suscitant de nombreuses attentes et doté de fortes promesses, peut avoir tendance à être utilisée de manière abusive, aussi bien dans un cadre professionnel (BtoB) que dans un cadre grand public (BtoC).

Mohamed Mansouri [19] souligne ainsi que « l’intelligence artificielle offre un potentiel marketing d’une telle puissance que le sens en est régulièrement dévoyé […] L’usage abusif des termes “Intelligence artificielle“ engendre un problème de loyauté à deux niveaux : à l’égard du public et entre professionnels ».

- Le caractère explicable ou transparence algorithmique

Les algorithmes utilisés tendent à être de plus en plus performants en raison des techniques dites d’apprentissage « profond » (deep learning) qui appartiennent à l’univers de l’apprentissage automatique. Plus ou moins sophistiquées, ces techniques sont intrinsèquement porteuses d’opacité : elles reposent sur des procédures non volontairement construites pour être des boîtes noires, mais qui si elles « fonctionnent selon un principe transparent et bien compris […] produisent des décisions dont il est impossible d’expliciter les raisons et le cheminement » [20].

- Le leurre et son corollaire, le respect

L’IA, au travers de ses multiples utilisations, peut donner l’impression que la machine est intelligente, sensible, voire empathique ou bienveillante. Or, si elle est capable de reproduire ou plus exactement de simuler ce qu’un être humain ferait ou dirait, donc si elle est capable de certaines performances, elle n’est en réalité pas comme un être humain, elle n’est pas dotée de capacités aussi diversement performantes. De plus, aucune intelligence artificielle ne ressent les choses, n’éprouve des émotions, n’accède à la conscience. En effet, les agents conversationnels, par exemple, « ne comprennent pas l’information qu’ils traitent […], n’ont pas de sens commun, ne comprennent pas les règles sociales ; ils répondent à des questions sans se préoccuper de l’historique, ni du contexte de la conversation, d’où un dialogue qui paraît souvent simpliste ou incohérent » [21]. Le roboticien Raja Chatila explique au travers d’un exemple de reconnaissance d’image, la différence importante qui existe entre la capacité à parfaitement identifier un objet, une image, un personnage et la capacité de réellement savoir ce qu’est l’objet, l’image, le personnage : « on peut montrer autant de millions d’images de chats qu’on veut à un système d’apprentissage profond pour qu’il reconnaisse un chat, il ne saura jamais ce qu’est un chat. Pour le savoir, il faut le caresser, se faire griffer, écouter son ronronnement … Bref interagir avec lui par tous les moyens perceptifs et à travers des actions, et c’est cette expérience qui devient pour nous la définition du chat » [22].

Si ce point est important ici, c’est parce qu’entrer en communication c’est créer une relation. Mais le message n’est pas la communication, même s’il en fait partie. Ainsi, si la machine ou plus exactement une Intelligence Artificielle « dit », écrit ou exprime d’une façon ou d’une autre le message : « je vous aime », elle ne nous aime pas vraiment. Elle simule au travers de l’expression d’un message et si elle prend la forme d’un robot, elle peut aussi être programmée pour que sa carnation et le plissement de ses yeux changent à ce moment-là. Cette simulation ne crée pas une interrelation entre l’IA et nous. L’IA sait dire au bon moment, à la bonne personne « je vous aime », mais elle ne sait pas ce que cela veut dire. Elle peut seulement faire semblant … et très bien faire semblant. Au point de nous leurrer en vertu de notre irrésistible propension à l’anthropocentrisme, au point de créer une relation déséquilibrée : de nous à elle alors qu’il n’y a aucune relation de cette nature de elle vers nous.

- L’isolement

Le ciblage, qu’il soit de nature publicitaire ou non, peut conduire à des effets « pervers » : s’il promet de nous offrir des contenus, produits, etc. correspondant mieux à notre personnalité car davantage liés à nos centres d’intérêt, il peut aussi déboucher sur :

- la discrimination, l’exclusion : en raison de l’identification algorithmique de ce que (qui) nous sommes, on se voit proposer une autre version de l’offre, une version « plus » ou une version « moins ». On peut même ne plus du tout avoir accès à certaines offres : elles nous sont comme interdites.

- l’enfermement dans une boucle de rétroaction : le phénomène a été décrit en 2016 de façon détaillée, à la suite du vote sur le Brexit, par la rédactrice en chef du Guardian, Katharine Viner – How technology disrupted the truth [23] – et repris par Hubert Guillaume du journal Le Monde [24] qui explique que « le fonctionnement des médias numériques favorise une boucle de rétroaction qui auto-renforce chaque choix que nous faisons, qui personnalise nos contenus et nous isole davantage dans notre propre bulle de filtres ». C’est ce qui correspond au biais de confirmation en psychologie sociale qui présente le risque de favoriser l’émergence des théories du complot (cf. Gérald Bronner, La démocratie des crédules, Presses Universitaires de France, 2013).

- L’éducation

Le rapport Villani considère comme axe prioritaire le développement de la recherche et par voie de conséquence l’accroissement du nombre d’étudiants dans ce secteur de l’IA.

Cependant, il ne faudrait pas occulter le fait que le grand public, celui qui n’est ni spécialiste, ni forcené de la programmation, ne comprend pas grand-chose à ce qu’est l’IA et ne dispose pas du minimum de connaissances nécessaires pour se prémunir aussi bien d’un engouement béat que d’appréhensions injustifiées [25].

- La fonction publicitaire elle-même

On aboutit ici à un paradoxe fort puisque le fait de confier à une IA le soin de décider et de choisir avec certitude (peut-être illusoire, mais annoncée comme telle) quel bien ou service nous allons acquérir, annihile le rôle même de la publicité dans sa fonction persuasive mais aussi de construction d’un territoire de marque. On peut affirmer, en effet, que le calcul des meilleures conditions de coût ou basées sur des caractéristiques propres au consommateur, réduit, voire annule, l’influence publicitaire.

Quelques exemples aujourd’hui d’utilisation de l’IA en marketing et publicité.

En préliminaire, il convient de remarquer que si des « créations » peuvent commencer à être produites par des algorithmes, il existe un territoire, celui de la créativité, bien différente de celui de la création de quelque chose, qui échappe encore et pour probablement longtemps aux attributs de l’intelligence artificielle. C’est ce qu’expliquent Serge Abitboul et Gilles Dowek, chercheurs à l’INRIA, dans le chapitre « un algorithme peut-il être amoureux ? » de leur ouvrage « Le temps des algorithmes » [26] : « La créativité, telle qu’elle s’exprime, par exemple, dans la création d’œuvres d’art, semble une faculté humaine bien difficile à simuler. Nous imaginons mal une muse inspirer un algorithme, quand les artistes eux-mêmes nous disent que le processus de création n’obéit à aucune règle, qu’ils ne le maîtrisent pas et que le fait qu’il leur échappe est précisément ce qui caractérise leur génie ».

Les exemples d’utilisation de l’IA en marketing et publicité concernent le plus souvent les possibilités de ciblage publicitaire sur Internet ou plus largement dans l’univers numérique, un ciblage de plus en plus fin et précis. Mais quelques exemples récents, qu’ils soient effectivement opérationnels ou pas encore, montrent que les tentations sont grandes et que l’avenir devrait révéler des performances techniques en matière d’utilisation de l’IA en marketing et publicité que nous ne soupçonnons pas aujourd’hui.

- Le printemps 2018 a connu un conflit sans précédent entre deux influenceuses sur Instagram : Lil Miquela et Bermuda [27], qui se sont révélées être des avatars créés par une société d’intelligence artificielle … qui en fait n’existait pas. S’il apparaît assez rapidement que « visuellement » les influenceuses sont bien des avatars, l’ambiguïté de leur statut humain-non humain est volontairement entretenue grâce notamment à la mise en scène du conflit. Ce sont donc les questions de transparence, de non tromperie, traitées par ailleurs par l’ARPP, qui doivent être considérées ici.

- Les assistants personnels, moteurs de recherche vocaux, associés aux smartphones (par exemple Siri pour l’Iphone) ou indépendants (par exemple, Google Home), sont susceptibles de proposer aux individus qui les questionnent une mise en avant de produits ou de marques dont la filiation publicitaire pourrait ne pas être évidente.

- Récemment, une chaîne de télévision a annoncé vouloir proposer aux annonceurs un ciblage émotionnel. La mise en œuvre conduirait donc, selon le contexte éditorial, à diffuser les publicités de marques souhaitant communiquer dans un environnement émotionnel ou un autre. La question à se poser ou les garanties à obtenir sont de s’assurer que si, tel que c’est annoncé, l’éditorial va conditionner la publicité diffusée, ce n’est pas le contraire qui se produira in fine, notamment pour les journaux télévisés, à la fois dans leur fond et dans leur forme.

- Le placement de produits peut aussi tirer avantage de la technologie IA [28] pour modifier en temps réel les produits apparaissant dans les vidéos ou séries afin de s’adapter à la cible recherchée. Les questions relatives à la déontologie et règlementation en matière de placement de produit, si elles se posent dans les mêmes termes théoriques, risquent de se heurter à une dimension pratique et à l’enjeu du repérage et de la traçabilité de ces actions, si jamais il y a dérive, en raison de leur caractère essentiellement éphémère.

- Dans le même ordre d’idées, la DCO (Dynamic Creative Optimization) permet d’adapter en temps réel la création ou certaines des composantes du message en fonction de l’individu ciblé sur Internet à l’occasion d’un achat d’espace publicitaire programmatique : la question de nouveau est notamment celle de la transparence et de la possibilité de refus déjà évoquée plus haut.

Ces quelques exemples ne visent pas à l’exhaustivité mais à mettre en évidence des potentialités dont on ne parvient pas à percevoir les contours ou plus exactement les limites. Ils illustrent dans quelle immense salle de jeu, la vigilance doit à présent opérer. C’est dans cet esprit que les recommandations qui suivent ont été réfléchies.

Recommandations

Compte tenu du caractère mouvant des phénomènes dont il est question, de l’évolution permanente des technologies et de ce qu’elles impliquent, aucune recommandation ne peut être envisagée comme une recette miracle ; c’est avant tout un message de vigilance qui doit être délivré :

S’assurer que la complexité des technologies mises en œuvre et les promesses d’innovations qu’elles apportent n’occultent pas la nécessaire vigilance sur les données personnelles.

Cf. Avis CEP “Big data”.

Considérer l’utilisation abusive de la terminologie « intelligence artificielle », que ce soit dans un cadre professionnel ou dans un cadre grand public, comme étant assimilable à de la publicité trompeuse.

Exercer une veille critique sur l’usage des mots et expressions utilisés à propos de l’IA, des algorithmes et des technologies associées, analyser les évolutions de sens par rapport à l’évolution objective de ces techniques afin de mettre en évidence les dérives sémantiques auxquelles l’utilisation de certains termes peuvent conduire dans l’esprit des publics, y compris professionnels.

S’assurer que le recours à l’intelligence artificielle et plus largement aux algorithmes est clairement annoncé au public, qu’il s’agisse de proposition de contenus, de produits, de publicité, ou de l’utilisation d’agents conversationnels, par exemple sur des sites marchands.

Permettre au public de ne pas voir ses choix être limités par les décisions algorithmiques, que ce soit en matière de publicité ou d’offre de produits, s’il ne le souhaite pas. Permettre au public dans ce domaine de ne pas être contraint des décisions algorithmiques est un élément majeur ; on pourrait aller au-delà et imaginer que les algorithmes puissent générer du hasard, du mélange, de l’imprévu.

On pourrait défendre un droit à la sérendipité pour éviter que les algorithmes ne deviennent des accélérateurs du déterminisme social, de l’isolement et de l’entre soi, et permettre qu’au contraire ils contribuent à la mixité et à la rencontre entre les gens. On pourrait imaginer ce type de processus à certains moments, ou à la demande, ou sur certains sujets.

Eviter la confusion qui pourrait exister, de manière délibérée ou fortuite, entre échanges entre humains, échanges entre humain et machine, échanges entre machine et machine.

Rendre traçables les algorithmes d’intelligence artificiels, non seulement au moment de leur conception, mais aussi tout au long de leur évolution, dès lors qu’ils reposent sur des procédures d’apprentissage automatique. Exiger la transparence, la loyauté et l’égalité des algorithmes d’IA. Pour cela il faut recommander la publication des algorithmes, ou des codes sources, comme annoncé par Emmanuel Macron pour « Parcoursup » [29].

Mettre en place des outils de mesure indépendants permettant de déterminer l’intensité de l’isolement créé par le recours aux algorithmes de l’IA, ce qui veut dire des études longitudinales sur l’usage de l’IA. En déduire les règles de bonne conduite pour minimiser les risques associés. Auditer les algorithmes d’IA a posteriori pour identifier les biais ethniques, sociaux ou culturels.

Assurer aux citoyens le minimum d’éducation en matière d’IA : à la fois pour les populations adultes et pour les enfants dans le cadre de leurs apprentissages scolaires afin de préparer les générations futures à ces nouveaux enjeux.

Instaurer une vigilance notamment au travers d’une veille sur le développement des robots et de l’IA et la façon dont la communication publicitaire va continuer à investir ce nouveau champ. Compte tenu de la dynamique de l’IA, cette veille doit procéder selon une méthode itérative.

Cet Avis piloté par Zysla Belliat, Rapporteur, réunit et synthétise les réflexions du groupe de travail du CEP composé de Laurence Devillers, Alain Grangé-Cabane, Samuel Lepastier, Pierre-Marie Lledo, Aurélie Martzel et Rémy Sautter.

Adopté le 17 décembre 2018

Annexe : quelques éléments de vocabulaire et concepts

Intelligence [30]

L’intelligence est un concept polysémique complexe qui recouvre de nombreuses notions. Il n’existe pas une intelligence mais plusieurs formes d’intelligence qui se traduisent par différentes « compétences » parmi lesquelles :

- La capacité d’adaptation au changement

- La capacité d’apprentissage

- La capacité à interpréter les règles culturelles et sociales

- La créativité

- La compréhension et l’organisation du réel en concepts

- La capacité à utiliser le raisonnement causal

- La capacité de prospection et la flexibilité

- L’habileté à percevoir et exprimer les émotions, à les intégrer pour comprendre, dialoguer et raisonner

- La capacité à réguler les émotions chez soi et chez les autres.

Intelligence artificielle

Dès les années 1950, les chercheurs comme John Mc Carthy donnent pour objectif de l’Intelligence Artificielle de « doter des machines de systèmes informatiques ayant des capacités intellectuelles comparables à celles de l’homme ».

En termes de définition de l’Intelligence Artificielle : « discipline scientifique recherchant des méthodes de résolution de problèmes à forte complexité logique ou algorithmique. Par extension, elle désigne dans le langage courant, les dispositifs imitant ou remplaçant l’humain dans certaines mises en œuvre de ses fonctions cognitives » [31]

Algorithme

Ensemble fini de procédures automatisées représentant une série d’opérations ou d’instructions plus ou moins complexes à effectuer afin d’atteindre un objectif prédéterminé ou de résoudre un problème.

La multiplication est un exemple d’algorithme simple, une recette de cuisine aussi.

Apprentissage automatique

L’apprentissage automatique est aussi appelé apprentissage statistique. Il s’agit d’un des domaines de l’IA qui consiste à recourir à des méthodes permettant à une machine (au sens large) d’évoluer par un processus systématique, et ainsi de remplir des tâches difficiles ou problématiques par des moyens algorithmiques plus classiques. Les algorithmes utilisés permettent, dans une certaine mesure, à un système piloté par ordinateur (un robot éventuellement), ou assisté par ordinateur, d’adapter ses analyses et ses comportements en réponse, en se fondant sur l’analyse de données empiriques provenant d’une base de données ou de capteurs. [32]

On classe ces algorithmes « en trois grandes catégories : apprentissage supervisé (l’algorithme construit un modèle des données annoté par des experts), non supervisé (l’algorithme découvre lui-même la structure des données) et par renforcement (l’algorithme procède par essais et erreurs, chaque erreur lui permettant d’améliorer sa performance dans la résolution du problème) » [33]

Apprentissage profond (Deep learning) – Réseaux de neurones

Ensemble de méthodes d’apprentissage automatique tentant de modéliser avec un haut niveau d’abstraction des données grâce à des architectures articulées de différentes transformations non linéaires. Le concept d’apprentissage profond prend forme dans les années 2010, avec la convergence de trois facteurs :

- des réseaux de neurones artificiels multicouches (eux-mêmes issus entre autres du concept de perceptron, datant de la fin des années 1950) :

- des algorithmes d’analyse discriminante et apprenants (dont l’émergence remonte aux années 1980) ;

- des machines dont la puissance de traitement permet de traiter des données massives [34].

Agent conversationnel (chatbot)

Programme informatique capable de simuler une conversation avec un ou plusieurs humains par échange vocal ou textuel [35].

Robot

Le mot robot vient du tchèque robota (travail, corvée) utilisé pour la 1ère fois par Karel Čapek dans une pièce de théâtre.

« Un robot est une machine comportant au moins trois éléments : des capteurs pour comprendre l’environnement dans lequel elle se trouve, des processeurs qui analysent les paramètres recueillis pour prendre une décision et des actionneurs qui lui permettent d’agir dans le monde réel. Certains robots sont aussi dotés de la possibilité de dialoguer et d’apprendre à partir de l’interaction avec les humains » [36].

Conscience (artificielle)

« […] Le concept de conscience a de nombreux sens que l’on peut s’efforcer de distinguer, bien que dans certains cas ces différences soient surtout des différences de degré : la conscience comme sensation, la conscience de soi, la conscience intellectuelle (intuition des essences ou des concepts), la conscience phénoménale (en tant que structure de notre expérience), etc. La modélisation de la conscience de soi pour un robot est un défi de recherche. Les autres niveaux de conscience seront impossibles à atteindre pour un robot dans l’état de nos connaissances » [37].

[1] On peut discuter ce point, car la notion d’algorithme peut être appliquée aux processus de calcul en général : une banale multiplication est un algorithme ! Ce qui tend à « désacraliser » l’expression utilisée parfois avec une pointe de pédantisme…

[2] https://www.kantarmedia.com/fr/blog-et-ressources/blog/20-utilisations-innovantes-de-l-intelligence-artificielle-pour-votre-marketing

[3] https://www.economie.gouv.fr/files/files/PDF/2017/Rapport_synthese_France_IA_.pdf

[4] http://www.enseignementsup-recherche.gouv.fr/cid128618/la-strategie-ia-pour-faire-de-la-france-un-acteur-majeur-de-l-intelligence-artificielle.html

[5] Nature vol 556 avril 2018

[6] Centre National de Ressources Textuelles et Lexicales : http://www.cnrtl.fr/definition/idiosyncrasie

[7] http://www.lemonde.fr/idees/article/2017/12/14/il-faut-creer-un-comite-national-d-ethique-du-numerique_5229661_3232.html

[8] ALLISTENE : Alliance des sciences et technologies du numérique

[9] http://cerna-ethics-allistene.org/CERNA+/

[10] Professeur à l’Université Pierre et Marie Curie, Directeur de l’Institut des Systèmes Intelligents et de Robotique

[11] http://www.lemonde.fr/sciences/article/2018/03/11/on-va-brouiller-la-frontiere-entre-l-homme-et-le-robot_5269174_1650684.html

[12] Laurence Devillers (2017) « Des robots et des hommes, mythes, fantasmes et réalité », Plon, Epilogue 227-228 :

- Données privées : Tu ne divulgueras pas mes données à n’importe qui

- Droit à l’oubli : Tu oublieras tout si je te le demande

- Sécurité : Tu pourras te déconnecter d’Internet si je te le demande

- Contrôle : Tu seras régulièrement contrôlé pour évaluer ce que tu as appris

- Explicabilité et traçage : Tu pourras toujours m’expliquer tes comportements si je te le demande

- Loyauté : Tu seras loyal

- Consentement : Tu seras empathique et simuleras des émotions seulement si je le sais

- Risque de dépendance : Tu stimuleras ma mémoire et veilleras à ce que je ne devienne pas trop dépendant de toi

- Risque de confusion : Tu feras attention à ce que je ne te confonde pas avec un être humain

- Adaptation aux règles sociales : Tu apprendras à vivre avec des humains et tu t’adapteras aux règles sociales

- Utilité et bienveillance : Tu seras bienveillant et utile. Et pourquoi pas, doué d’un peu d’humour

[13] Rapport N°1 de La CERNA : http://cerna-ethics-allistene.org/digitalAssets/38/38704_Avis_robotique_livret.pdf

[14] Rapport N°3 de La CERNA : http://cerna-ethics-allistene.org/digitalAssets/54/54730_cerna_2017_machine_learning.pdf

[15]https://www.cnil.fr/fr/comment-permettre-lhomme-de-garder-la-main-rapport-sur-les-enjeux-ethiques-des-algorithmes-et-de

[16] http://afcia-association.fr/ – Onglet : MANIFESTE DE L’AFCIA

[17] « Les transhumanistes, en désirant « s’augmenter » eux-mêmes, courent en fait vers leur dissolution, et ils y entraînent le reste du monde » (ibid.)

[18] https://www.cep-pub.org/avis/avis-publicite-et-big-data/

[19] Mohamed Mansouri (2018) « L’intelligence artificielle et la publicité : quelle éthique ? », Série trimestrielle ENJEUX NUMERIQUES des Annales des Mines – Enjeux numériques, N°1 Mars 2018. L’intelligence Artificielle : un enjeu d’économie et de civilisation. 53-58

[20] Laurence Devillers (2017) « Tester les robots pour bien vivre avec ». Pour La Science N° 476 Juin 2017

[21] Ibid.

[22] http://www.lemonde.fr/sciences/article/2018/03/11/on-va-brouiller-la-frontiere-entre-l-homme-et-le-robot_5269174_1650684.html

[23] https://www.theguardian.com/media/2016/jul/12/how-technology-disrupted-the-truth

[24] http://internetactu.blog.lemonde.fr/2016/09/17/la-propagande-des-algorithmes-vraiment/

[25] http://www.liberation.fr/voyage-au-coeur-de-lIA/2017/12/15/l-intelligence-artificielle-fait-machine-avant_1616976

[26] Essai paru chez Le Pommier, 2017, page 185

[27] https://www.rtbf.be/lapremiere/article/detail_des-influenceuses-virtuelles-qui-se-prennent-le-bec-alors-qu-elles-n-existent-pas?id=9909506

[28] https://www.rtbf.be/lapremiere/article/detail_des-influenceuses-virtuelles-qui-se-prennent-le-bec-alors-qu-elles-n-existent-pas?id=9909506

[29] http://www.europe1.fr/politique/parcoursup-macron-souhaite-la-publication-de-lalgorithme-3613013

[30] Laurence Devillers (2017) « Tester les robots pour bien vivre avec ». Pour La Science N° 476 Juin 201

[31] Ibid.

[32] D’après Wikipédia https://fr.wikipedia.org/wiki/Apprentissage_automatique

[33] Laurence Devillers (2017) « Des robots et des hommes, mythes, fantasmes et réalité », Plon, Glossaire 229-234

[34] D’après Wikipedia https://fr.wikipedia.org/wiki/Apprentissage_profond

[35] https://www.futura-sciences.com/tech/definitions/internet-chatbot-15778/

[36] Laurence Devillers (2017) « Des robots et des hommes, mythes, fantasmes et réalité », Plon, Glossaire 229-234

[37] Ibid.

Paris, le 3 janvier 2018